A Qualidade da Máquina que Sonha

No meio da "jobpocalypse" e promessas de AGI, por que o Engenheiro de Qualidade nunca foi tão essencial.

Se há um tema que monopolizou os holofotes da tecnologia recentemente – e arrisco dizer, da sociedade como um todo – é a Inteligência Artificial. Das conversas de corredor aos keynotes inflamados, a IA deixou de ser um verbete de glossário futurista para se tornar uma presença quase palpável, prometendo revoluções e, para alguns, agitando o fantasma da obsolescência. Como engenheiros de qualidade, calejados por ciclos de hype e disrupções reais, nosso instinto é um só: onde, exatamente, aterrissa a qualidade nesse novo paradigma?

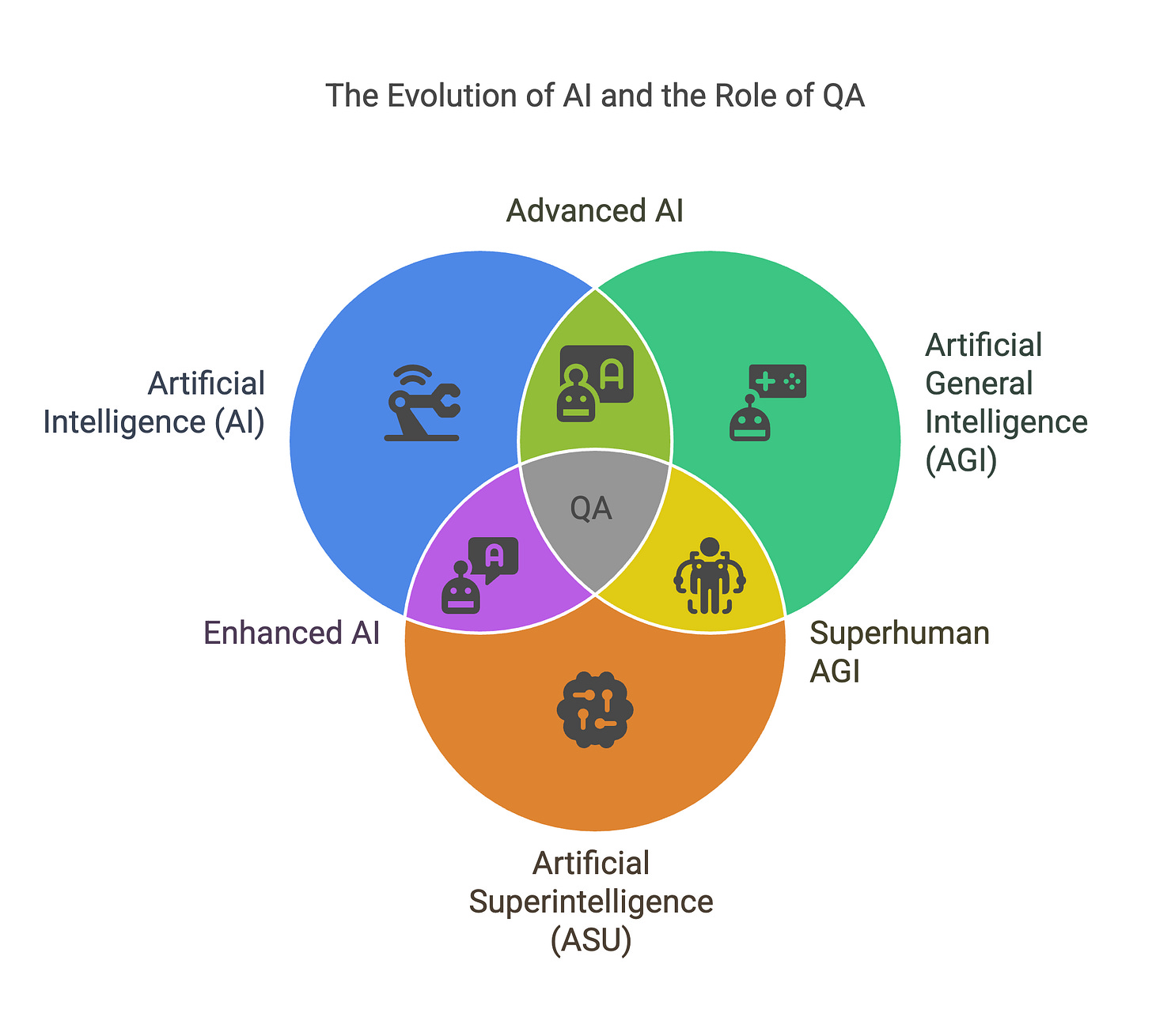

O Dilema dos Extremos: AI 2027 vs. AI Snake Oil

Para navegar neste nevoeiro de expectativas, é interessante observar as correntes de pensamento que se formam. Em um extremo, temos projeções como as do paper "AI 2027" de Daniel Kokotajlo.[1] O documento desenha uma linha do tempo acelerada, onde a Inteligência Artificial Geral (AGI) não é uma miragem distante, mas uma realidade iminente, com Agentes de IA evoluindo de "personal assistants" para entidades capazes de "tomar instruções via Slack ou Teams e fazer mudanças substanciais de código por conta própria"[1] já em 2025, culminando em sistemas onde, por volta de junho de 2027, "a maioria dos humanos na OpenBrain não consegue mais contribuir utilmente".[1] O paper prevê um cenário onde "uma Inteligência Artificial Superior (ASI)... ultrapassando em muito a capacidade humana"[1] se torna o próximo passo, alimentando o debate sobre um "Jobpocalypse" (para quem quiser saber mais sobre a posição de Kokatajlo, sugiro o podcast Interesting Times, do New York Times, conduzido por Ross Douthat [3]),

Do outro lado do ringue, temos a visão mais cautelosa, quase cética, de especialistas como Arvind Narayanan, de Princeton. Em suas análises, como a apresentada no artigo da universidade, "AI Snake Oil"[2], Narayanan nos lembra que "AI snake oil, como conceito, é IA que não funciona como anunciado e provavelmente não pode funcionar como anunciado".[2] Ele distingue crucialmente entre a IA generativa, que captura a imaginação popular, e a "IA preditiva", que, segundo ele, é a que "está realmente amplamente implantada – que estará invisivelmente tomando decisões massivamente consequentes sobre a vida das pessoas".[2] Narayanan argumenta que, embora haja "progresso técnico notável"[2] em algumas áreas, "há tanta IA falha sendo vendida"[2] que a confusão é generalizada.

E Nós com Isso? O Engenheiro de Qualidade na Era da IA

Entre a singularidade iminente e o ceticismo do "óleo de cobra", onde fica o nosso estimado ofício de Engenheiro de Qualidade? Se os "Agent-4" de Kokotajlo estão prestes a nos superar em todas as tarefas cognitivas[1], penduramos as chuteiras? Ou, se grande parte é hype, como sugere Narayanan, podemos seguir validando APIs como se nada tivesse mudado?

Acredito que a verdade, como quase sempre na engenharia, reside na complexidade do "depende" – e é justamente aí que nosso valor não apenas persiste, mas se multiplica. A IA, seja ela um assistente turbinado ou o embrião de uma AGI, introduz novas ordens de magnitude em complexidade, opacidade e, sejamos francos, potencial para falhas espetaculares.

Mais do que "Testar o Código": Garantindo a Qualidade do Software que Faz Software

Pensem na teia de integrações: modelos de IA se conectando a sistemas legados que mal foram documentados, interagindo com microsserviços ágeis, respondendo a regras de negócio que mudam com a velocidade de um tweet e, tudo isso, sob o escrutínio de regulações cada vez mais apertadas, legislações complexas e mercados globais. Quem vai garantir que o "cérebro" da IA não apenas aprendeu os padrões corretos, mas que suas inferências são consumíveis, seus resultados são rastreáveis e suas "decisões" não geram um passivo milionário ou, pior, um dano irreparável?

Aqui, nosso papel evolui. Deixamos de ser os garantidores da qualidade do software desenvolvido por humanos para nos tornarmos os garantidores da qualidade do software que faz software. Nossa missão se expande para validar os próprios processos de treinamento, a representatividade e o viés dos dados, a robustez dos modelos frente a entradas adversariais e a interpretabilidade (ou a falta dela) das "caixas-pretas" algorítmicas. Precisamos assegurar que essas soluções de IA não apenas "funcionem", mas que entreguem resultados consistentes, auditáveis e, crucialmente, integráveis de forma segura e eficaz.

A Falácia do Volume e a Lembrança da Automação: Lições do Passado

"Mas uma IA pode executar trilhões de testes em segundos!", alguns podem contra-argumentar, vendo na própria IA a solução definitiva para o teste de IA. É uma meia-verdade perigosa. Sim, a capacidade de processamento é vasta. Contudo, executar um trilhão de testes ineficazes, ou testes que não cobrem os cenários de contorno realmente críticos, ou testes que não foram corretamente treinados nas regras de negócio, ou testes cujos resultados não conseguimos interpretar ou confiar, não nos leva a lugar nenhum. A força bruta sem inteligência estratégica é apenas força bruta.

Eu me lembro de quando a automação de testes começou a ganhar tração. O burburinho era similar: "Os QAs vão desaparecer!", "A automação vai pegar todos os bugs!". O que realmente aconteceu? Nós, QAs, arregaçamos as mangas, aprendemos a programar, a desenhar frameworks, a pensar em automação de forma estratégica. Absorvemos mais essa competência. A IA é a nova "automação de testes" nesse sentido: uma ferramenta poderosa que, em vez de nos substituir, exigirá que nos elevemos, que nos tornemos ainda mais analíticos e críticos.

Potencializando o QA com IA: Novos Horizontes

Longe de ser uma ameaça, a IA pode ser uma aliada formidável para o engenheiro de qualidade sagaz. Imaginem o poder de analisar terabytes de logs de produção para identificar padrões anômalos de comportamento que nenhum humano conseguiria detectar em tempo hábil. Pensem em "asserts semânticos" em testes de API, onde uma IA auxiliar poderia verificar não apenas se o status code é 200, mas se a semântica da resposta faz sentido dentro do contexto da requisição e do negócio. E a capacidade de gerar dados de teste massivos e diversificados, cobrindo cenários que nossa imaginação limitada talvez não alcançasse? Ou analisar vastos repositórios de defeitos para prever áreas de risco em futuras sprints? As possibilidades são imensas para quem estiver disposto a aprender e adaptar. Mas, de novo, com supervisão de engenheiros de qualidade.

Ainda Não Há Bala de Prata: Qualidade Consciente em um Mundo de IA

A lição de Fred Brooks em "No Silver Bullet" continua tão relevante quanto em 1986. Não há solução mágica para a complexidade inerente ao desenvolvimento de software. A IA, por mais transformadora que seja, não é essa bala de prata. Como já discuti anteriormente em meu artigo "Test Automation is not a Silver Bullet"[4], depositar fé cega em uma única tecnologia ou abordagem como panaceia costuma ser uma receita para o desapontamento, ou pior, para introduzir novos e mais complexos problemas.

A IA adiciona uma camada extra de "não-bala-de-prata". Ela pode acelerar, pode ampliar, pode descobrir, mas a responsabilidade final pela qualidade, pela ética, pela segurança e pelo impacto real no usuário e no negócio continua sendo intrinsecamente humana – e, ouso dizer, cada vez mais do engenheiro de qualidade.

O Futuro é Qualidade

Enquanto o debate sobre AGI, ASI e o futuro do trabalho segue fervoroso, uma coisa me parece clara: a demanda por profissionais capazes de pensar criticamente sobre sistemas complexos, de questionar premissas, de desenhar estratégias de validação robustas e de entender profundamente o porquê além do como, só vai aumentar.

O engenheiro de qualidade de software não está à beira da extinção; estamos à beira de uma reinvenção, de uma elevação de nosso papel estratégico. O futuro não é apenas construir IAs mais inteligentes; é construir IAs com qualidade, de forma responsável. E essa tarefa tem o nosso nome escrito por toda parte.

Fontes